Không Biết Cách Viết Prompts? Hãy Xem Tại Đây!

Không Biết Cách Viết Prompts? Hãy Xem Tại Đây!

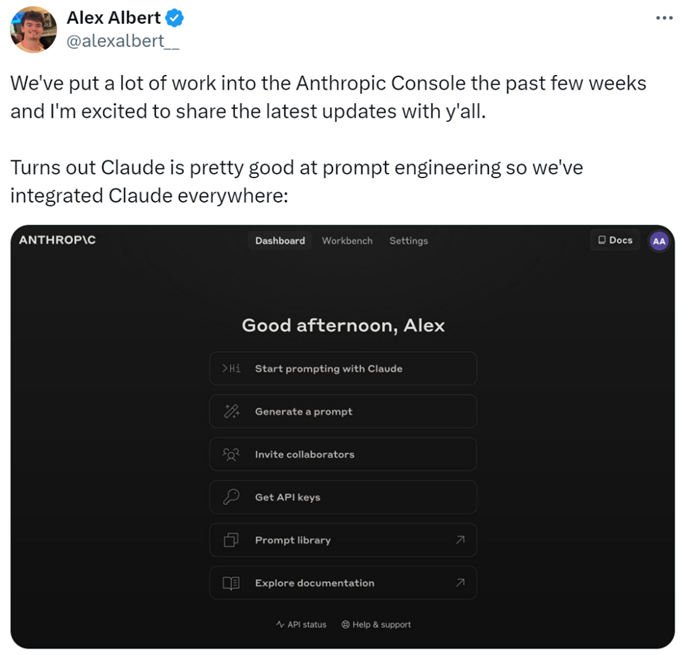

Trong lĩnh vực phát triển ứng dụng AI, chất lượng của các prompt ảnh hưởng đáng kể đến kết quả. Tuy nhiên, việc tạo ra các prompt chất lượng cao có thể gặp khó khăn, yêu cầu các nhà nghiên cứu phải có sự hiểu biết sâu sắc về nhu cầu ứng dụng và chuyên môn về các mô hình ngôn ngữ lớn. Để rút ngắn thời gian phát triển và cải thiện kết quả, công ty khởi nghiệp AI Anthropic đã đơn giản hóa quy trình này, giúp người dùng dễ dàng tạo ra các prompt chất lượng cao.

Cụ thể, các nhà nghiên cứu đã thêm các tính năng mới vào Anthropic Console, cho phép tạo, kiểm tra và đánh giá các prompt.

Kỹ sư prompt của Anthropic, Alex Albert, cho biết: "Đây là kết quả của công việc đáng kể trong vài tuần qua, và bây giờ Claude xuất sắc trong kỹ thuật prompt."

Những Prompt Khó? Hãy Để Claude Lo!

Trong Claude, việc viết một prompt tốt đơn giản như việc mô tả nhiệm vụ. Console bao gồm một trình tạo prompt tích hợp sẵn được hỗ trợ bởi Claude 3.5 Sonnet, cho phép người dùng mô tả nhiệm vụ và để Claude tạo ra các prompt chất lượng cao.

Tạo Prompt: Đầu tiên, nhấp vào "Tạo Prompt" để vào giao diện tạo prompt:

Tiếp theo, nhập mô tả nhiệm vụ, và Claude 3.5 Sonnet sẽ chuyển đổi mô tả nhiệm vụ thành một prompt chất lượng cao. Ví dụ, "Viết một prompt để đánh giá các tin nhắn đến...", sau đó nhấp vào "Tạo Prompt."

Tạo Dữ Liệu Kiểm Tra: Nếu người dùng đã có một prompt, họ có thể cần một số trường hợp kiểm tra để thực hiện nó. Claude có thể tạo ra các trường hợp kiểm tra đó.

Người dùng có thể chỉnh sửa các trường hợp kiểm tra theo nhu cầu và chạy tất cả các trường hợp kiểm tra chỉ với một cú nhấp chuột. Họ cũng có thể xem và điều chỉnh hiểu biết của Claude về yêu cầu cho từng biến, cho phép kiểm soát tinh vi hơn về việc tạo trường hợp kiểm tra của Claude.

Các tính năng này giúp tối ưu hóa các prompt dễ dàng hơn, vì người dùng có thể tạo ra các phiên bản mới của prompt và chạy lại bộ kiểm tra để nhanh chóng lặp lại và cải thiện kết quả.

Thêm vào đó, Anthropic đã thiết lập một thang điểm năm điểm để đánh giá chất lượng phản hồi của Claude.

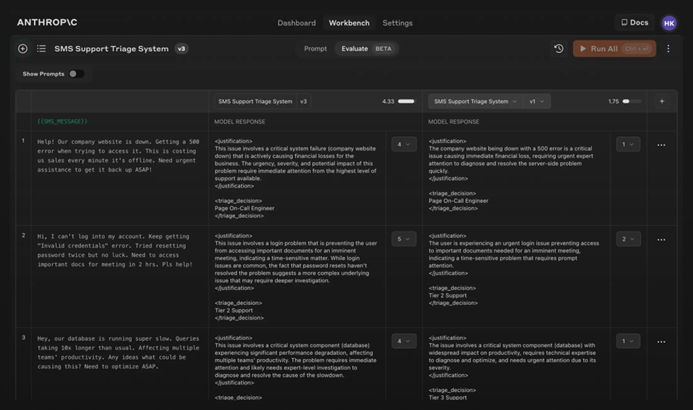

Đánh Giá Mô Hình: Nếu người dùng hài lòng với prompt, họ có thể chạy nó với nhiều trường hợp kiểm tra khác nhau trong tab "Đánh Giá". Người dùng có thể nhập dữ liệu kiểm tra từ các tệp CSV hoặc sử dụng Claude để tạo dữ liệu kiểm tra tổng hợp.

So Sánh: Người dùng có thể kiểm tra nhiều prompt với nhau trong các trường hợp kiểm tra và đánh giá các phản hồi tốt hơn để theo dõi prompt nào hoạt động tốt nhất.

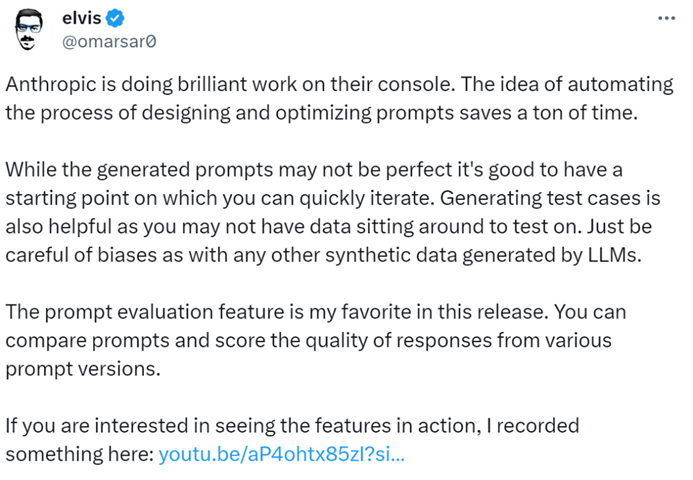

Nhà báo AI @elvis cho biết: "Anthropic Console là một công cụ xuất sắc, tiết kiệm rất nhiều thời gian với thiết kế tự động và quy trình tối ưu hóa prompt. Mặc dù các prompt được tạo ra có thể không hoàn hảo, nhưng chúng cung cấp một điểm khởi đầu cho việc lặp lại nhanh chóng. Thêm vào đó, tính năng tạo trường hợp kiểm tra là rất hữu ích, vì các nhà phát triển có thể không có dữ liệu sẵn có để kiểm tra."

Có vẻ như trong tương lai, việc viết các prompt có thể được giao cho Anthropic.

Để biết thêm thông tin, vui lòng kiểm tra tài liệu: https://docs.anthropic.com/en/docs/build-with-claude/prompt-engineering/overview.

Share this article

Related Posts

p>Nhiệm vụ viết một bài luận khoa học chính trị có thể có vẻ khó khăn, đặc biệt là khi xem xét các khái niệm phức tạp và phân tích sâu sắc mà các bài viết như vậy thường yêu cầu. Tuy nhiên, sự gia tăng của các trợ lý viết AI như AI Essay Writer của WriteGo đã biến đổi cách tiếp cận các nhiệm vụ học thuật này, làm cho quá trình trở nên hiệu quả và trực quan hơn. Dưới đây là cách bạn có thể tận dụng công cụ AI này để viết bài luận khoa học chính trị của mình.

span style="color:#16a085">Prompts