Vet du inte hur man skriver prompts? Titta hit!

Vet du inte hur man skriver prompts? Titta hit!

I AI-applikationsutveckling påverkar kvaliteten på prompts resultaten avsevärt. Att skapa högkvalitativa prompts kan dock vara en utmaning, vilket kräver att forskare har en djup förståelse för applikationens behov och expertis inom stora språkmodeller. För att påskynda utvecklingen och förbättra resultaten har AI-startupen Anthropic strömlinjeformat denna process, vilket gör det enklare för användare att skapa högkvalitativa prompts.

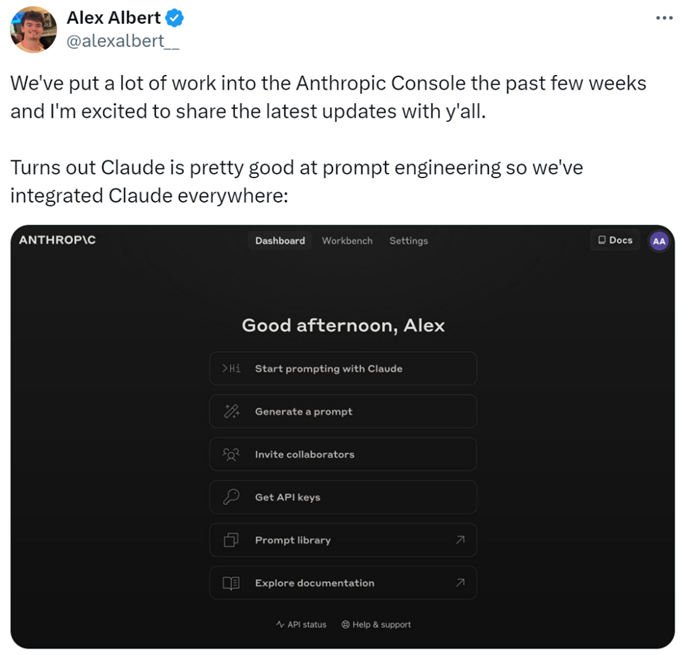

Specifikt har forskarna lagt till nya funktioner i Anthropic Console, vilket möjliggör generation, testning och utvärdering av prompts.

Anthropics promptingenjör Alex Albert uttalade: "Detta är resultatet av betydande arbete under de senaste veckorna, och nu excellerar Claude i promptteknik."

Svåra Prompts? Låt Claude ta hand om det

I Claude är det lika enkelt att skriva en bra prompt som att beskriva uppgiften. Konsolen inkluderar en inbyggd promptgenerator som drivs av Claude 3.5 Sonnet, vilket gör att användare kan beskriva uppgifter och få Claude att generera högkvalitativa prompts.

Generera Prompts: Först, klicka på "Generera Prompt" för att gå till gränssnittet för promptgenerering:

Fyll sedan i uppgiftsbeskrivningen, så kommer Claude 3.5 Sonnet att omvandla uppgiftsbeskrivningen till en högkvalitativ prompt. Till exempel, "Skriv en prompt för att granska inkommande meddelanden...", klicka sedan på "Generera Prompt."

Generera Testdata: Om användare har en prompt, kan de behöva några testfall för att köra den. Claude kan generera dessa testfall.

Användare kan modifiera testfallen efter behov och köra alla testfall med ett enda klick. De kan också se och justera Claudes förståelse för kraven för varje variabel, vilket möjliggör finare kontroll över Claudes testfallsgenerering.

Dessa funktioner gör det enklare att optimera prompts, eftersom användare kan skapa nya versioner av prompts och köra testsuiten för att snabbt iterera och förbättra resultaten.

Dessutom har Anthropic satt en fempunkts skala för att utvärdera Claudes svarskvalitet.

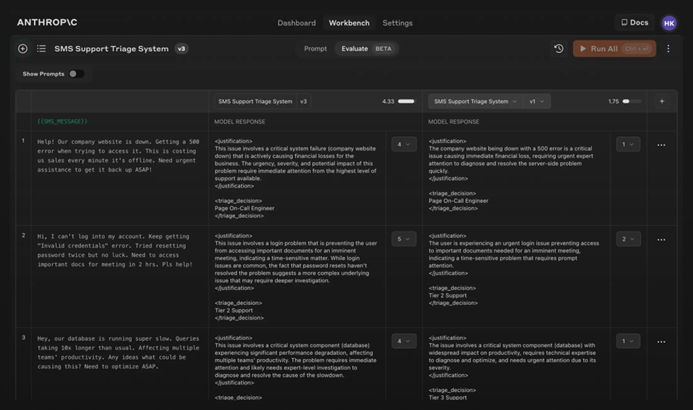

Utvärdera Modellen: Om användare är nöjda med prompten kan de köra den mot olika testfall i "Utvärdering"-fliken. Användare kan importera testdata från CSV-filer eller använda Claude för att generera syntetisk testdata.

Jämförelse: Användare kan testa flera prompts mot varandra i testfall och poängsätta de bättre svaren för att spåra vilken prompt som presterar bäst.

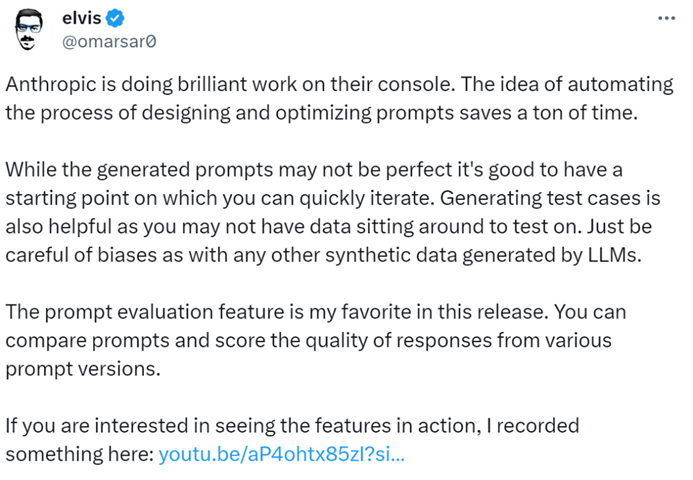

AI-bloggaren @elvis uttalade: "Anthropic Console är ett enastående verktyg som sparar mycket tid med sin automatiserade design och promptoptimeringsprocess. Även om de genererade prompts kanske inte är perfekta, ger de en snabb iterationspunkt. Dessutom är funktionen för generering av testfall mycket hjälpsam, eftersom utvecklare kanske inte har data tillgänglig för testning."

Det verkar som att i framtiden kan skrivandet av prompts överlämnas till Anthropic.

För mer information, vänligen kolla dokumentationen: https://docs.anthropic.com/en/docs/build-with-claude/prompt-engineering/overview.

Share this article

Related Posts

p>Att skriva en politologisk uppsats kan verka skrämmande, särskilt med tanke på de komplexa begrepp och djupgående analyser som sådana arbeten ofta kräver. Men framväxten av AI-skrivassistenter som WriteGo's AI Essay Writer har förändrat hur sådana akademiska uppgifter angrips, vilket gör processen både effektiv och intuitiv. Här är hur du kan utnyttja detta AI-verktyg för att skriva din politologiska uppsats.

span style="color:#16a085">prompts