Neviete, ako písať výzvy? Pozrite sa sem!

Neviete, ako písať výzvy? Pozrite sa sem!

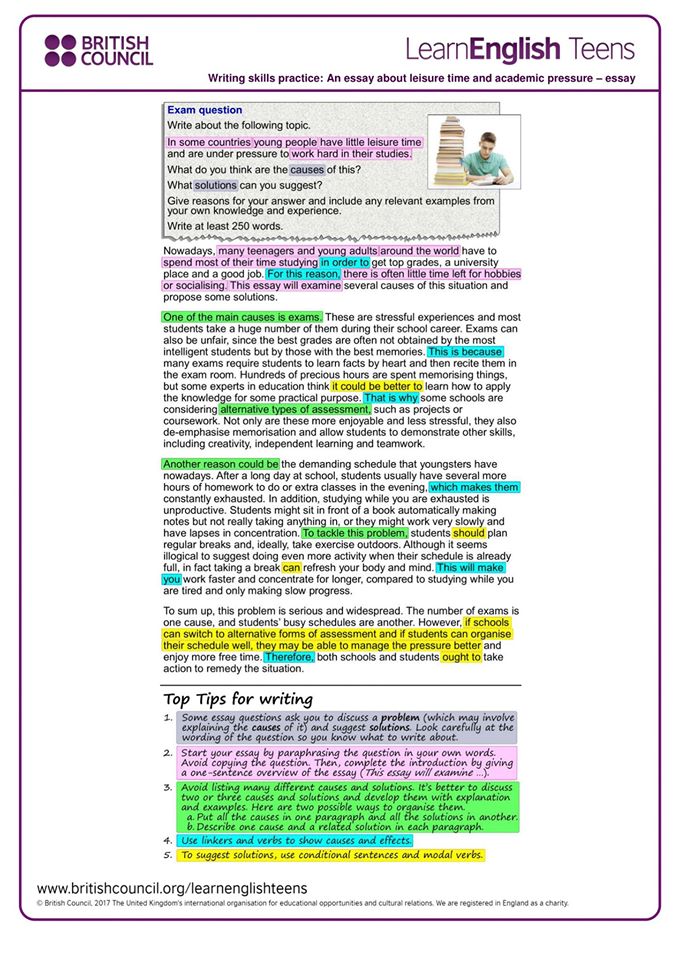

V oblasti vývoja aplikácií AI má kvalita výziev významný dopad na výsledky. Avšak, vytváranie kvalitných výziev môže byť náročné, čo vyžaduje od výskumníkov hlboké porozumenie potrebám aplikácie a odborné znalosti vo veľkých jazykových modeloch. Aby sa urýchlil vývoj a zlepšili výsledky, AI startup Anthropic zjednodušil tento proces, čím uľahčil používateľom vytvárať kvalitné výzvy.

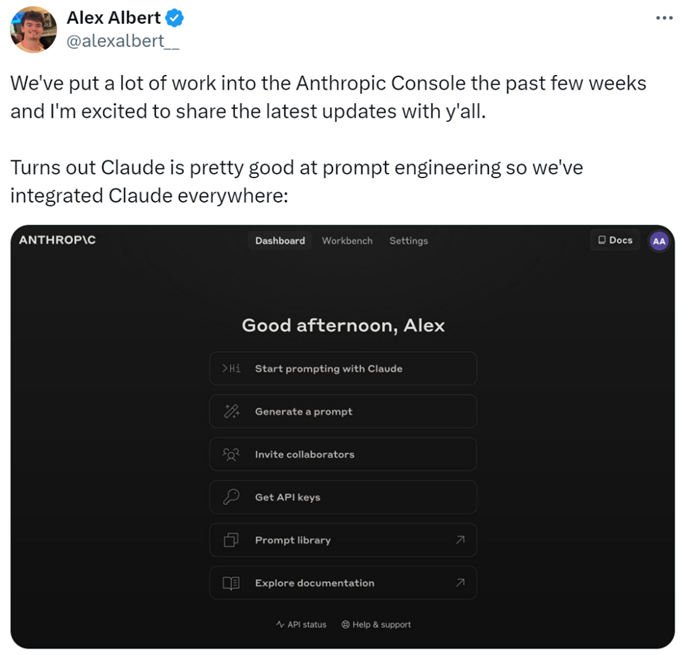

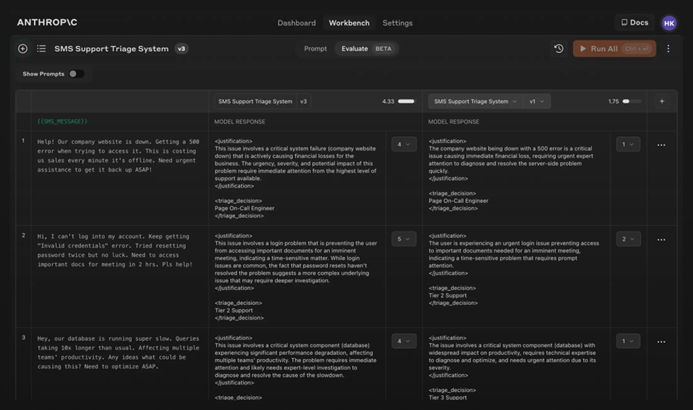

Konkrétne výskumníci pridali nové funkcie do Anthropic Console, ktoré umožňujú generovanie, testovanie a hodnotenie výziev.

Inžinier výziev Anthropic, Alex Albert, uviedol: "Toto je výsledok významnej práce za posledné týždne, a teraz Claude vyniká v inžinieringu výziev."

Ťažké výzvy? Nechajte to na Claudea

V Claude je písanie dobrej výzvy také jednoduché, ako opísať úlohu. Konzola zahŕňa vstavaný generátor výziev poháňaný Claude 3.5 Sonnet, ktorý umožňuje používateľom popísať úlohy a nechať Claude generovať kvalitné výzvy.

Generovanie výziev: Najprv kliknite na "Generovať výzvu" a prejdite do rozhrania generovania výziev:

Potom zadajte popis úlohy a Claude 3.5 Sonnet premení popis úlohy na kvalitnú výzvu. Napríklad, "Napíšte výzvu na recenzovanie prichádzajúcich správ...", potom kliknite na "Generovať výzvu."

Generovanie testovacích dát: Ak majú používatelia výzvu, môžu potrebovať niektoré testovacie prípady na jej spustenie. Claude môže generovať tieto testovacie prípady.

Používatelia môžu upraviť testovacie prípady podľa potreby a spustiť všetky testovacie prípady jedným kliknutím. Môžu tiež zobraziť a upraviť Claudeovo chápanie požiadaviek pre každú premennú, čo umožňuje jemnejšiu kontrolu nad generovaním testovacích prípadov Claudeom.

Tieto funkcie uľahčujú optimalizáciu výziev, pretože používatelia môžu vytvárať nové verzie výziev a znovu spustiť testovaciu sadu, aby rýchlo iterovali a zlepšili výsledky.

Okrem toho Anthropic stanovil päťbodovú škálu na hodnotenie kvality reakcií Claudea.

Hodnotenie modelu: Ak sú používatelia spokojní s výzvou, môžu ju spustiť proti rôznym testovacím prípadom na karte "Hodnotenie". Používatelia môžu importovať testovacie dáta z CSV súborov alebo použiť Claude na generovanie syntetických testovacích dát.

Porovnanie: Používatelia môžu testovať viacero výziev navzájom v testovacích prípadoch a ohodnotiť lepšie odpovede, aby sledovali, ktorá výzva funguje najlepšie.

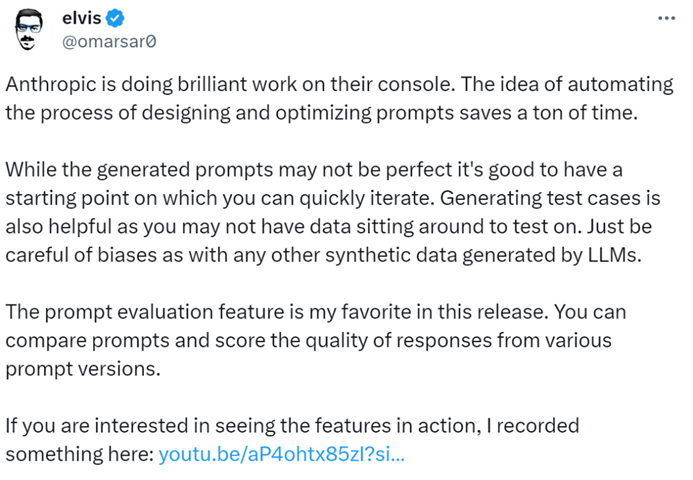

AI bloger @elvis uviedol: "Anthropic Console je vynikajúci nástroj, ktorý šetrí veľa času svojím automatizovaným dizajnom a optimalizáciou výziev. Aj keď generované výzvy nemusia byť dokonalé, poskytujú rýchly východiskový bod pre iterácie. Okrem toho je funkcia generovania testovacích prípadov veľmi užitočná, pretože vývojári nemusia mať k dispozícii dáta na testovanie."

Zdá sa, že v budúcnosti bude možné zveriť písanie výziev Anthropic.

Pre viac informácií prosím skontrolujte dokumentáciu: https://docs.anthropic.com/en/docs/build-with-claude/prompt-engineering/overview.

Sledujte WriteGo, aby ste dostávali najnovšie informácie o AI