Weet je niet hoe je prompts moet schrijven? Kijk hier!

Weet je niet hoe je prompts moet schrijven? Kijk hier!

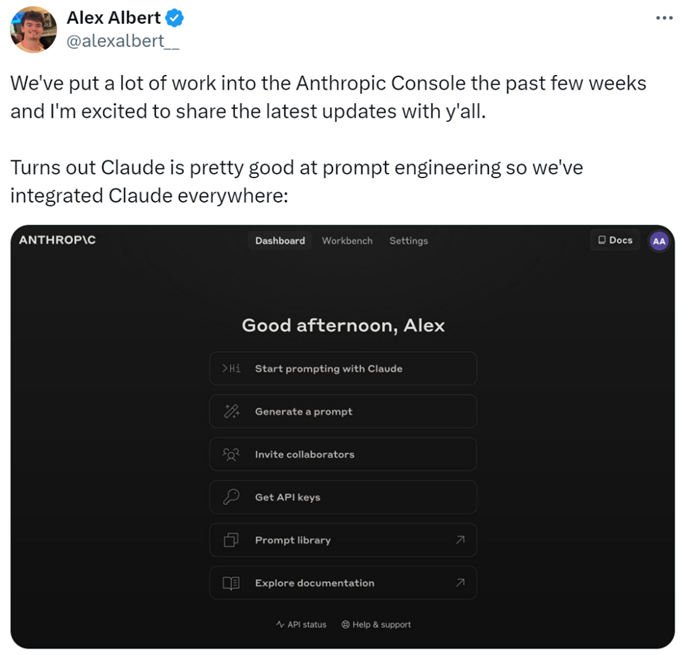

In de wereld van AI applicatieontwikkeling heeft de kwaliteit van prompts een significante impact op de resultaten. Het creëren van hoogwaardige prompts kan echter uitdagend zijn, omdat onderzoekers een diepgaand begrip van de behoeften van de applicatie en expertise in grote taalmodellen moeten hebben. Om de ontwikkeling te versnellen en de resultaten te verbeteren, heeft AI-startup Anthropic dit proces gestroomlijnd, waardoor het gemakkelijker wordt voor gebruikers om hoogwaardige prompts te creëren.

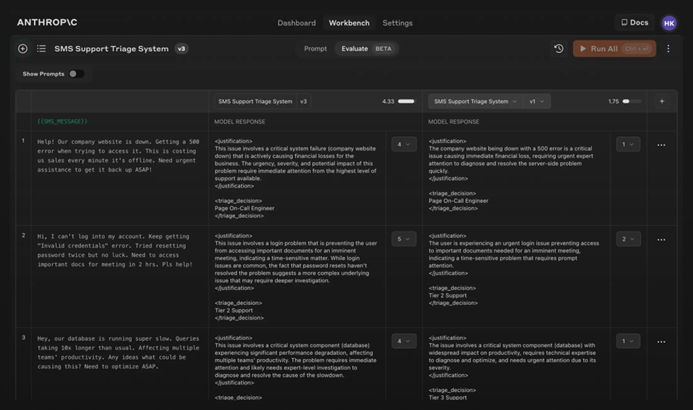

Specifiek hebben onderzoekers nieuwe functies toegevoegd aan de Anthropic Console, waarmee prompts kunnen worden gegenereerd, getest en geëvalueerd.

De prompt engineer van Anthropic, Alex Albert, verklaarde: "Dit is het resultaat van aanzienlijk werk in de afgelopen weken, en nu excelleert Claude in prompt engineering."

Moeilijke Prompts? Laat het aan Claude Over

Bij Claude is het schrijven van een goede prompt zo simpel als het beschrijven van de taak. De console bevat een ingebouwde promptgenerator aangedreven door Claude 3.5 Sonnet, waarmee gebruikers taken kunnen beschrijven en Claude hoogwaardige prompts kan laten genereren.

Genereren van Prompts: Klik eerst op "Genereer Prompt" om de interface voor het genereren van prompts te openen:

Voer vervolgens de taakbeschrijving in, en Claude 3.5 Sonnet zal de taakbeschrijving omzetten in een hoogwaardige prompt. Bijvoorbeeld, "Schrijf een prompt voor het beoordelen van inkomende berichten...," klik daarna op "Genereer Prompt."

Genereren van Testdata: Als gebruikers een prompt hebben, hebben ze mogelijk testgevallen nodig om deze uit te voeren. Claude kan die testgevallen genereren.

Gebruikers kunnen de testgevallen indien nodig aanpassen en alle testgevallen met één klik uitvoeren. Ze kunnen ook Claude's begrip van de vereisten voor elke variabele bekijken en aanpassen, wat fijnere controle over Claude's testgevalgeneratie mogelijk maakt.

Deze functies maken het optimaliseren van prompts gemakkelijker, omdat gebruikers nieuwe versies van prompts kunnen maken en de testsuite opnieuw kunnen uitvoeren om snel te itereren en de resultaten te verbeteren.

Bovendien heeft Anthropic een vijfpuntschaal ingesteld voor het evalueren van de kwaliteit van Claude's reacties.

Evalueren van het Model: Als gebruikers tevreden zijn met de prompt, kunnen ze deze uitvoeren tegen verschillende testgevallen in het tabblad "Evaluatie". Gebruikers kunnen testdata importeren uit CSV-bestanden of Claude gebruiken om synthetische testdata te genereren.

Vergelijking: Gebruikers kunnen meerdere prompts tegen elkaar testen in testgevallen en de betere reacties beoordelen om bij te houden welke prompt het beste presteert.

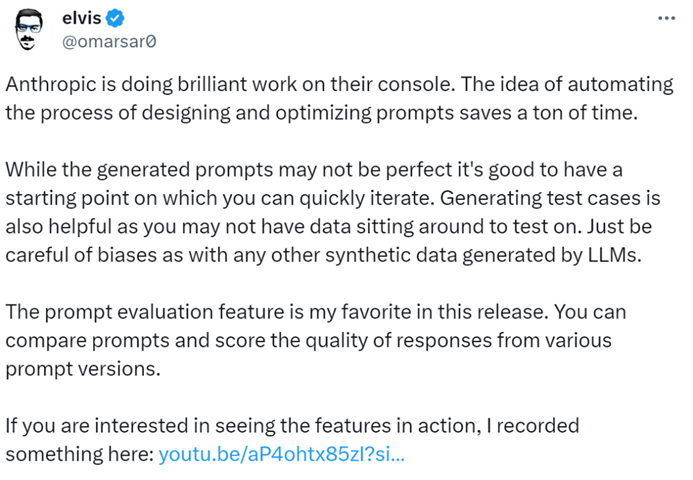

AI-blogger @elvis verklaarde: "Anthropic Console is een uitstekend hulpmiddel, dat veel tijd bespaart met zijn geautomatiseerde ontwerp en promptoptimalisatieproces. Hoewel de gegenereerde prompts misschien niet perfect zijn, bieden ze een snel iteratie-startpunt. Bovendien is de functie voor het genereren van testgevallen zeer nuttig, aangezien ontwikkelaars mogelijk geen gegevens beschikbaar hebben voor testen."

Het lijkt erop dat in de toekomst het schrijven van prompts aan Anthropic kan worden toevertrouwd.

Voor meer informatie, raadpleeg de documentatie: https://docs.anthropic.com/en/docs/build-with-claude/prompt-engineering/overview.

Share this article

Related Posts

p>De taak om een politicologie essay te schrijven kan ontmoedigend lijken, vooral gezien de complexe concepten en diepgaande analyses die dergelijke papers vaak vereisen. De opkomst van AI-schrijfhulpmiddelen zoals WriteGo's AI Essay Writer heeft echter de manier waarop dergelijke academische taken worden benaderd, getransformeerd, waardoor het proces zowel efficiënt als intuïtief wordt. Hier is hoe je dit AI-hulpmiddel kunt benutten om je politicologie essay te schrijven.

span style="color:#16a085">prompts