Vet du ikke hvordan du skriver prompts? Se her!

Vet du ikke hvordan du skriver prompts? Se her!

I utviklingen av AI-applikasjoner har kvaliteten på prompter stor innvirkning på resultatene. Å lage høy-kvalitets prompter kan imidlertid være utfordrende, og krever at forskere har en dyp forståelse av applikasjonsbehov og ekspertise innen store språkmodeller. For å fremskynde utviklingen og forbedre resultatene har AI-startupen Anthropic strømlinjeformet denne prosessen, noe som gjør det lettere for brukere å lage høy-kvalitets prompter.

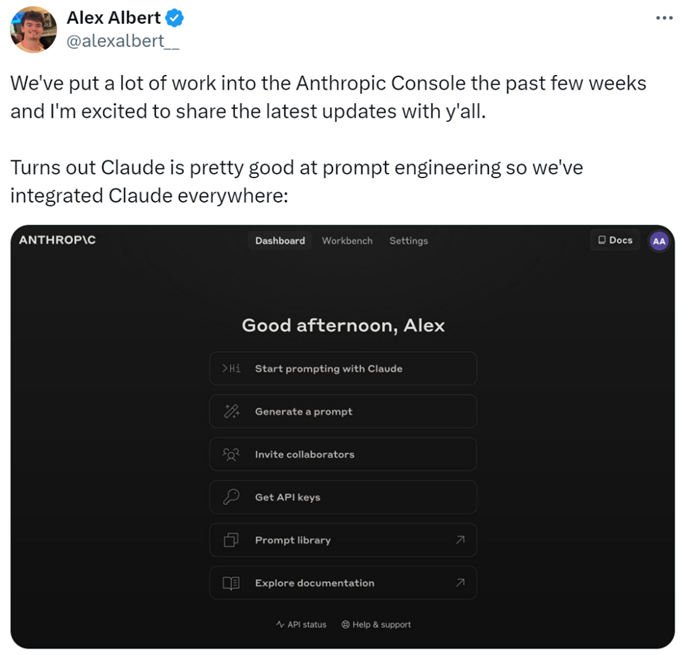

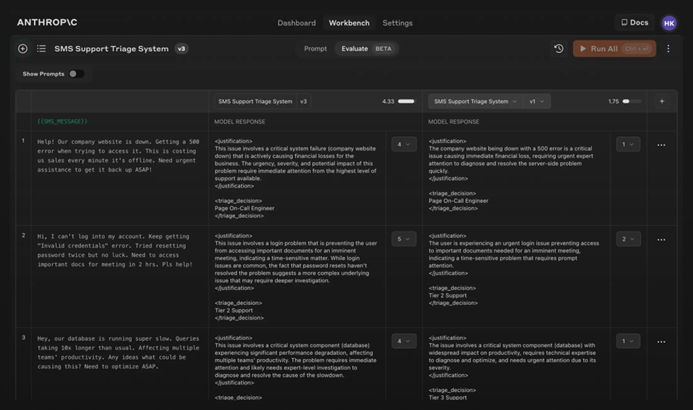

Spesifikt har forskere lagt til nye funksjoner i Anthropic Console, som gjør det mulig å generere, teste og evaluere prompter.

Anthropic sin promptingeniør Alex Albert uttalte: "Dette er resultatet av betydelig arbeid de siste ukene, og nå utmerker Claude seg i prompt engineering."

Vanskelige Prompter? La Claude Ta Seg Av Det

I Claude er det å skrive en god prompt så enkelt som å beskrive oppgaven. Konsollen inkluderer en innebygd promptgenerator drevet av Claude 3.5 Sonnet, som lar brukere beskrive oppgaver og la Claude generere høy-kvalitets prompter.

Generere Prompter: Først, klikk på "Generer Prompt" for å gå inn i grensesnittet for promptgenerering:

Deretter, skriv inn oppgavebeskrivelsen, og Claude 3.5 Sonnet vil konvertere oppgavebeskrivelsen til en høy-kvalitets prompt. For eksempel, "Skriv en prompt for å gjennomgå innkommende meldinger...", og klikk deretter på "Generer Prompt."

Generere Testdata: Hvis brukere har en prompt, kan de trenge noen testtilfeller for å kjøre den. Claude kan generere disse testtilfellene.

Brukere kan endre testtilfellene etter behov og kjøre alle testtilfeller med ett klikk. De kan også se og justere Claudes forståelse av kravene for hver variabel, noe som muliggjør finere kontroll over Claudes generering av testtilfeller.

Dessa funksjoner gjør det enklere å optimalisere prompter, da brukere kan lage nye versjoner av prompter og kjøre testsettet på nytt for raskt å iterere og forbedre resultatene.

I tillegg har Anthropic satt en fem-punkts skala for å evaluere kvaliteten på Claudes svar.

Evaluere Modellen: Hvis brukere er fornøyd med prompten, kan de kjøre den mot ulike testtilfeller i "Evaluering"-fanen. Brukere kan importere testdata fra CSV-filer eller bruke Claude til å generere syntetiske testdata.

Sammenligning: Brukere kan teste flere prompter mot hverandre i testtilfeller og gi poeng til de bedre svarene for å spore hvilken prompt som presterer best.

AI-blogger @elvis uttalte: "Anthropic Console er et fremragende verktøy, som sparer mye tid med sin automatiserte design og prosess for promptoptimalisering. Selv om de genererte prompter kanskje ikke er perfekte, gir de et raskt iterasjonsutgangspunkt. I tillegg er funksjonen for generering av testtilfeller veldig nyttig, da utviklere kanskje ikke har data tilgjengelig for testing."

Det ser ut til at i fremtiden kan skriving av prompter overlates til Anthropic.

For mer informasjon, vennligst sjekk dokumentasjonen: https://docs.anthropic.com/en/docs/build-with-claude/prompt-engineering/overview.