Wissen Sie nicht, wie man Eingabeaufforderungen schreibt? Schauen Sie hier!

Wissen Sie nicht, wie man Eingabeaufforderungen schreibt? Schauen Sie hier!

Im Bereich der Entwicklung von KI-Anwendungen hat die Qualität der Eingabeaufforderungen einen erheblichen Einfluss auf die Ergebnisse. Das Erstellen hochwertiger Eingabeaufforderungen kann jedoch eine Herausforderung darstellen, da Forscher ein tiefes Verständnis der Anwendungsbedürfnisse und Expertise in großen Sprachmodellen benötigen. Um die Entwicklung zu beschleunigen und die Ergebnisse zu verbessern, hat das KI-Startup Anthropic diesen Prozess optimiert, sodass es für Benutzer einfacher wird, hochwertige Eingabeaufforderungen zu erstellen.

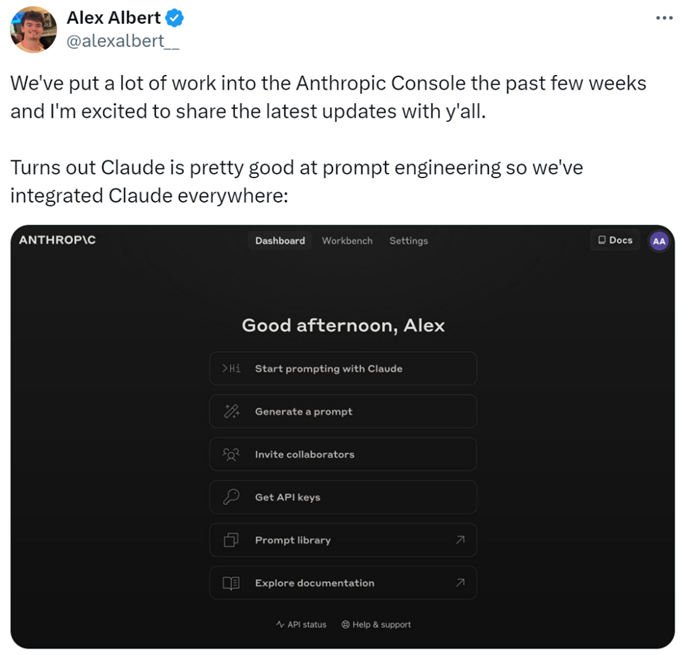

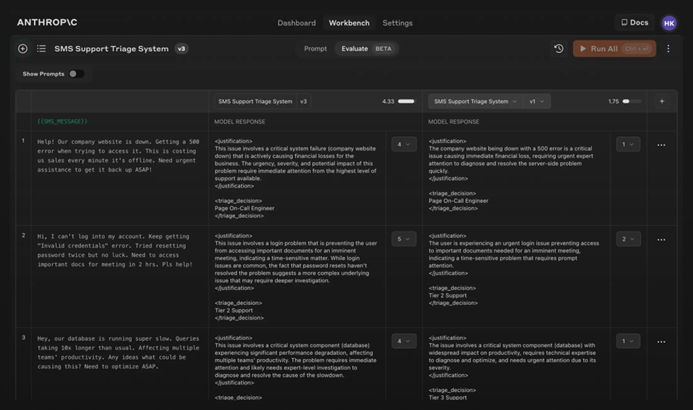

Konkret haben die Forscher neue Funktionen zur Anthropic Console hinzugefügt, die die Generierung, das Testen und die Bewertung von Eingabeaufforderungen ermöglichen.

Der Eingabeaufforderungsingenieur von Anthropic, Alex Albert, erklärte: "Dies ist das Ergebnis erheblicher Arbeit in den letzten Wochen, und jetzt glänzt Claude im Eingabeaufforderungsengineering."

Schwierige Eingabeaufforderungen? Überlassen Sie es Claude

Bei Claude ist das Schreiben einer guten Eingabeaufforderung so einfach wie das Beschreiben der Aufgabe. Die Konsole enthält einen integrierten Eingabeaufforderungsgenerator, der von Claude 3.5 Sonnet betrieben wird, mit dem Benutzer Aufgaben beschreiben und Claude hochwertige Eingabeaufforderungen generieren lassen können.

Eingabeaufforderungen generieren: Klicken Sie zuerst auf "Eingabeaufforderung generieren", um die Eingabeaufforderungsgenerierungsoberfläche zu betreten:

Geben Sie dann die Aufgabenbeschreibung ein, und Claude 3.5 Sonnet wird die Aufgabenbeschreibung in eine hochwertige Eingabeaufforderung umwandeln. Zum Beispiel: "Schreiben Sie eine Eingabeaufforderung zur Überprüfung eingehender Nachrichten...", und klicken Sie dann auf "Eingabeaufforderung generieren."

Testdaten generieren: Wenn Benutzer eine Eingabeaufforderung haben, benötigen sie möglicherweise einige Testfälle, um sie auszuführen. Claude kann diese Testfälle generieren.

Benutzer können die Testfälle nach Bedarf anpassen und alle Testfälle mit einem einzigen Klick ausführen. Sie können auch Claudes Verständnis der Anforderungen für jede Variable anzeigen und anpassen, um eine genauere Kontrolle über Claudes Testfallgenerierung zu ermöglichen.

Diese Funktionen erleichtern die Optimierung von Eingabeaufforderungen, da Benutzer neue Versionen von Eingabeaufforderungen erstellen und die Testsuite erneut ausführen können, um schnell zu iterieren und die Ergebnisse zu verbessern.

Darüber hinaus hat Anthropic eine fünfstufige Skala zur Bewertung der Antwortqualität von Claude festgelegt.

Das Modell bewerten: Wenn Benutzer mit der Eingabeaufforderung zufrieden sind, können sie sie gegen verschiedene Testfälle im Tab "Bewertung" ausführen. Benutzer können Testdaten aus CSV-Dateien importieren oder Claude verwenden, um synthetische Testdaten zu generieren.

Vergleich: Benutzer können mehrere Eingabeaufforderungen gegeneinander in Testfällen testen und die besseren Antworten bewerten, um zu verfolgen, welche Eingabeaufforderung am besten abschneidet.

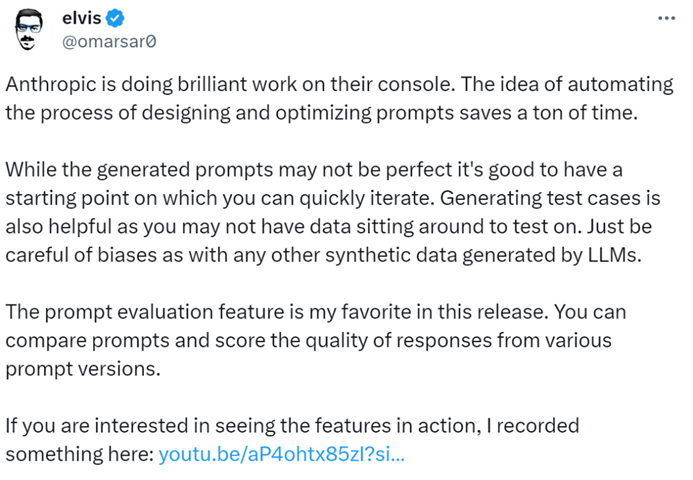

Der KI-Blogger @elvis erklärte: "Die Anthropic Console ist ein herausragendes Tool, das viel Zeit mit ihrem automatisierten Design und dem Prozess der Eingabeaufforderungsoptimierung spart. Auch wenn die generierten Eingabeaufforderungen möglicherweise nicht perfekt sind, bieten sie einen schnellen Ausgangspunkt für Iterationen. Darüber hinaus ist die Funktion zur Generierung von Testfällen sehr hilfreich, da Entwickler möglicherweise keine Daten für Tests zur Verfügung haben."

Es scheint, dass das Schreiben von Eingabeaufforderungen in Zukunft Anthropic anvertraut werden kann.

Für weitere Informationen lesen Sie bitte die Dokumentation: https://docs.anthropic.com/en/docs/build-with-claude/prompt-engineering/overview.

Folgen Sie WriteGo, um die neuesten KI-Informationen zu erhalten

Share this article

Related Posts

p>Die Aufgabe, einen Politikwissenschafts-Essay zu schreiben, kann entmutigend erscheinen, insbesondere angesichts der komplexen Konzepte und der tiefgehenden Analysen, die solche Arbeiten oft erfordern. Der Aufstieg von KI-Schreibassistenten wie dem KI-Essay-Schreiber von WriteGo hat jedoch die Herangehensweise an solche akademischen Aufgaben revolutioniert und den Prozess sowohl effizient als auch intuitiv gestaltet. Hier erfahren Sie, wie Sie dieses KI-Tool nutzen können, um Ihren Politikwiss

span style="color:#16a085">Eingabeaufforderungen