Ved du ikke, hvordan man skriver prompts? Se her!

Ved du ikke, hvordan man skriver prompts? Se her!

I udviklingen af AI-applikationer har kvaliteten af prompts en betydelig indflydelse på resultaterne. At skabe høj-kvalitets prompts kan dog være udfordrende, da det kræver, at forskere har en dyb forståelse af applikationens behov og ekspertise i store sprogmodeller. For at fremskynde udviklingen og forbedre resultaterne har AI-startupen Anthropic strømlinet denne proces, hvilket gør det lettere for brugerne at skabe høj-kvalitets prompts.

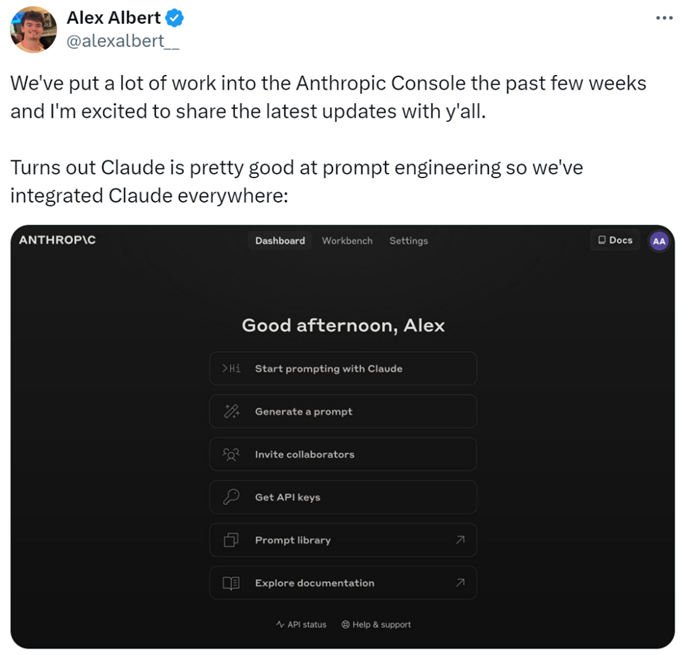

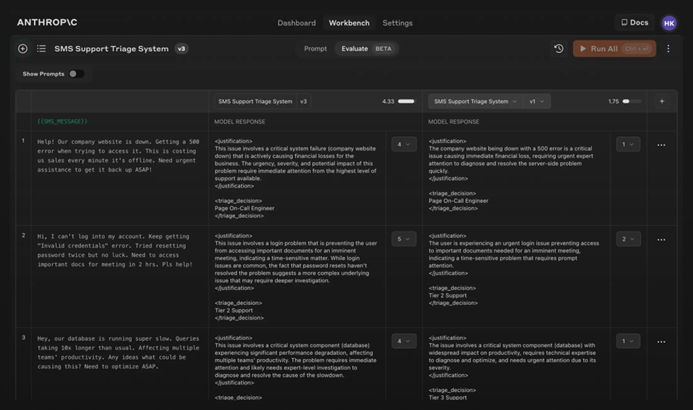

Specifikt har forskerne tilføjet nye funktioner til Anthropic Console, som muliggør generering, test og evaluering af prompts.

Anthropics promptingeniør Alex Albert sagde: "Dette er resultatet af betydeligt arbejde i de seneste uger, og nu excellerer Claude i prompt engineering."

Vanskelige Prompts? Lad Claude klare det

I Claude er det så simpelt at skrive en god prompt som at beskrive opgaven. Console inkluderer en indbygget promptgenerator drevet af Claude 3.5 Sonnet, som gør det muligt for brugerne at beskrive opgaver og få Claude til at generere høj-kvalitets prompts.

Generering af Prompts: Først skal du klikke på "Generer Prompt" for at komme ind i promptgenereringsgrænsefladen:

Indtast derefter opgavebeskrivelsen, og Claude 3.5 Sonnet vil konvertere opgavebeskrivelsen til en høj-kvalitets prompt. For eksempel, "Skriv en prompt til at gennemgå indgående beskeder...", og klik derefter på "Generer Prompt."

Generering af Testdata: Hvis brugerne har en prompt, kan de have brug for nogle testtilfælde til at køre den. Claude kan generere disse testtilfælde.

Brugerne kan ændre testtilfældene efter behov og køre alle testtilfælde med et enkelt klik. De kan også se og justere Claudes forståelse af kravene til hver variabel, hvilket giver finere kontrol over Claudes generation af testtilfælde.

Denne funktion gør det lettere at optimere prompts, da brugerne kan skabe nye versioner af prompts og køre testsuiten for hurtigt at iterere og forbedre resultaterne.

Derudover har Anthropic fastsat en fem-punkts skala til evaluering af Claudes responskvalitet.

Evaluering af Modellen: Hvis brugerne er tilfredse med prompten, kan de køre den mod forskellige testtilfælde i "Evaluering" fanen. Brugerne kan importere testdata fra CSV-filer eller bruge Claude til at generere syntetiske testdata.

Sammenligning: Brugerne kan teste flere prompts mod hinanden i testtilfælde og score de bedre svar for at spore, hvilken prompt der præsterer bedst.

AI-blogger @elvis sagde: "Anthropic Console er et fremragende værktøj, der sparer meget tid med sin automatiserede design- og promptoptimeringsproces. Selvom de genererede prompts måske ikke er perfekte, giver de et hurtigt iterationsstartpunkt. Derudover er funktionen til generering af testtilfælde meget nyttig, da udviklere måske ikke har data til rådighed til testning."

Det ser ud til, at skrivning af prompts i fremtiden kan overlades til Anthropic.

For mere information, se venligst dokumentationen: https://docs.anthropic.com/en/docs/build-with-claude/prompt-engineering/overview.