Nevíte, jak psát výzvy? Podívejte se sem!

Nevíte, jak psát výzvy? Podívejte se sem!

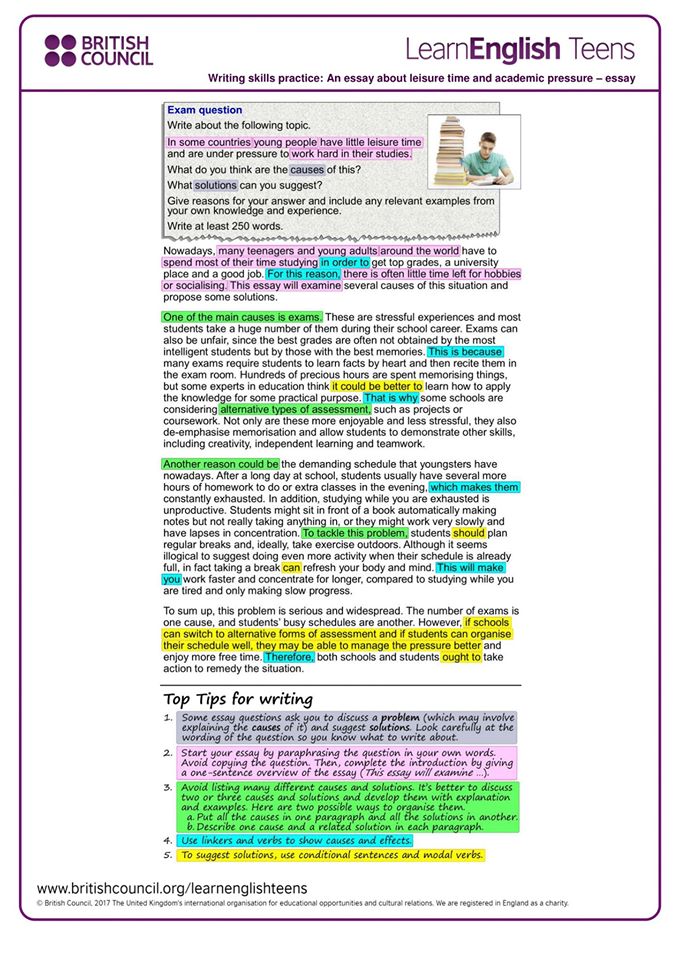

V oblasti vývoje aplikací AI má kvalita výzev významný dopad na výsledky. Nicméně, vytváření kvalitních výzev může být náročné, vyžadující od výzkumníků hluboké porozumění potřebám aplikací a odborné znalosti v oblasti velkých jazykových modelů. Aby se urychlil vývoj a zlepšily výsledky, startup AI Anthropic zjednodušil tento proces, což uživatelům usnadňuje vytváření kvalitních výzev.

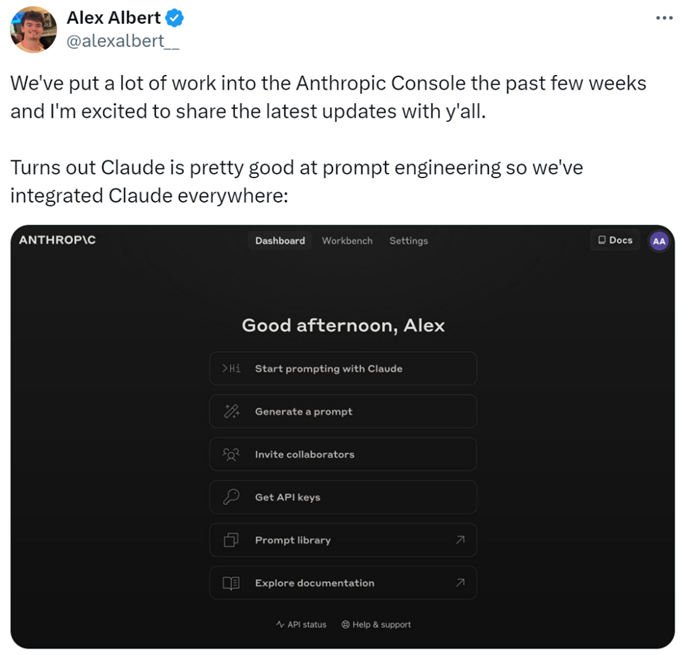

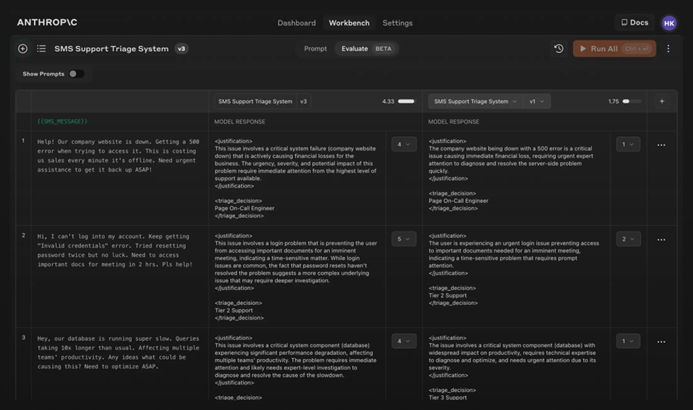

Konkrétně výzkumníci přidali nové funkce do Anthropic Console, které umožňují generování, testování a vyhodnocování výzev.

Inženýr výzev Anthropic Alex Albert uvedl: "To je výsledek významné práce v posledních týdnech, a nyní Claude exceluje v inženýrství výzev."

Obtížné výzvy? Nechte to na Claudeovi

V Claudeovi je psaní dobré výzvy tak jednoduché, jako popsat úkol. Console obsahuje vestavěný generátor výzev poháněný Claude 3.5 Sonnet, který uživatelům umožňuje popsat úkoly a nechat Claude generovat kvalitní výzvy.

Generování výzev: Nejprve klikněte na "Generovat výzvu" pro vstup do rozhraní generování výzev:

Poté zadejte popis úkolu a Claude 3.5 Sonnet převede popis úkolu na kvalitní výzvu. Například: "Napište výzvu pro přezkoumání příchozích zpráv...", a poté klikněte na "Generovat výzvu."

Generování testovacích dat: Pokud mají uživatelé výzvu, mohou potřebovat některé testovací případy k jejímu provedení. Claude může tyto testovací případy generovat.

Uživatelé mohou testovací případy upravit podle potřeby a spustit všechny testovací případy jediným kliknutím. Mohou také vidět a upravit Claudeovo porozumění požadavkům pro každou proměnnou, což umožňuje jemnější kontrolu nad generováním testovacích případů Claudeem.

Tyto funkce usnadňují optimalizaci výzev, protože uživatelé mohou vytvářet nové verze výzev a znovu spouštět testovací sadu, aby rychle iterovali a zlepšili výsledky.

Navíc Anthropic stanovila pětibodovou škálu pro hodnocení kvality odpovědí Claudea.

Vyhodnocení modelu: Pokud jsou uživatelé spokojeni s výzvou, mohou ji spustit proti různým testovacím případům v záložce "Hodnocení". Uživatelé mohou importovat testovací data z CSV souborů nebo použít Claudea k generování syntetických testovacích dat.

Porovnání: Uživatelé mohou testovat více výzev proti sobě v testovacích případech a hodnotit lepší odpovědi, aby sledovali, která výzva funguje nejlépe.

AI blogger @elvis uvedl: "Anthropic Console je vynikající nástroj, který šetří spoustu času díky svému automatizovanému designu a procesu optimalizace výzev. I když generované výzvy nemusí být dokonalé, poskytují rychlý výchozí bod pro iteraci. Navíc je funkce generování testovacích případů velmi užitečná, protože vývojáři nemusí mít k dispozici data pro testování."

Zdá se, že v budoucnu lze psaní výzev svěřit Anthropic.

Pro více informací prosím zkontrolujte dokumentaci: https://docs.anthropic.com/en/docs/build-with-claude/prompt-engineering/overview.